发布时间:2025-11-27 来源:MicroDisplay

11月28日消息,Meta 技术负责人 Jinsong Yu 近日在 QCon London 演讲中深度拆解了 AR 眼镜 Orion 的核心技术架构,这款被称为世界迄今为止最先进的全功能 AR 原型,以不到 100 克、无线、透明镜片为核心目标,在光学、散热、交互等领域实现多项突破性创新,同时为 AR 行业的技术研发与产品落地提供了关键经验。

AR 的本质

在解析 Orion 前,需明确 AR(增强现实)与 VR(虚拟现实)、MR(混合现实)的本质区别。VR是完全阻断物理环境感知,通过封闭显示实现沉浸式虚拟体验。MR是依赖摄像头是穿透式显示来呈现环境,物理设备仍阻挡光线。AR则是以透明镜片为基础,在真实物理世界上叠加虚拟内容,既保留现实视野,又支持他人与使用者的眼神交流。这是 Orion 的核心定位,例如在物理墙上叠加虚拟电视、让远方亲友以全息形式出现在客厅。

Orion 的核心硬件系统

Orion 并非单一设备,而是由眼镜本体、EMG 腕带、计算模块三部分构成,通过硬件分工实现轻便佩戴与功能完整的平衡。

眼镜本体

作为体验核心,眼镜本体集成了 Orion 最关键的技术创新,核心目标是 在 100 克内实现广视场角、全息显示与安全散热。

光学系统:定制 Micro LED + 碳化硅波导。为避免传统 AR 镜片厚且重的问题,Orion 采用镜腿 Micro LED 光引擎+ 碳化硅波导镜片方案。

Micro LED 光引擎为 Meta 定制,追求全球最小像素密度,安装于镜腿前侧,是虚拟内容的光子来源。

镜片采用碳化硅材质, 这是全球首次将碳化硅用于 AR 波导制造,其高折射率特性解决了传统高折射率塑料厚且大的缺陷,能让 Micro LED 发出的光子在镜片内多次反射后,精准传入人眼,最终实现 70 度视场角,让虚拟内容贴合真实物体。此外,眼镜搭载四朝外摄像头和两朝内摄像头,朝外摄像头负责捕捉环境几何(为后续世界锁定做准备),朝内摄像头通过红外照明追踪眼球位置,定位用户注视焦点。

散热方案:11 个定制 MCU 的分布式计算。传统小型设备依赖单一 SoC(片上系统),但 Orion 若采用此方案,会因摄像头计算、眼动追踪、显示驱动等多任务集中负载,形成致命热点,甚至导致元件融化。为此,Meta 创新采用 11 个定制微控制器(MCU)的分布式架构,将计算任务分散到多个芯片,避免单点过热。同时,配合计算模块卸载重负载任务,最终实现眼镜本体的轻量化与温度安全 。即便内部无一丝间隙浪费,仍能稳定运行,且续航达 2 小时。

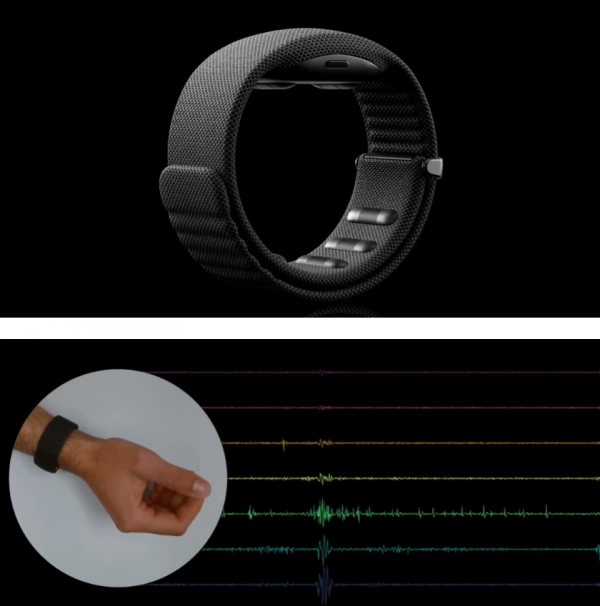

EMG 腕带

Orion 的输入核心之一是表面肌电图(EMG)腕带,解决 AR 场景无键盘、无触摸屏的交互难题。

原理:通过皮肤表面传感器拾取肌肉收缩产生的微伏级电信号,经放大与机器学习模型处理,识别用户手势(如拇指点击食指、滑动等)。

关键突破:在手表大小的设备中实现 18 小时续航。通过模型精简与能效优化,将机器学习推理功耗控制在微瓦级,且无需侵入式植入电极,佩戴方式与普通手表一致,手势操作可隐蔽进行(如手放口袋中即可触发)。

计算模块

计算模块是 Orion 的算力中枢,虽采用无显示器 Android的标准架构,却承担核心功能。

定位:作为大脑运行所有业务逻辑与呈现逻辑,眼镜与 EMG 腕带仅作为外围设备。

散热优化:曾因高负载导致需用冰苏打水降温,后通过减少内存拷贝、优化调度与 API,将温度控制在合理范围, 印证了硬件性能还需软件打磨。

关键架构设计

Orion 的核心用户体验依赖两大架构创新,一是世界锁定渲染,另一个为多模态输入融合,这个解决了 AR 场景中虚拟内容漂移与交互不自然的行业痛点。

世界锁定渲染

若采用传统头部锁定渲染,虚拟内容会随头部移动而漂移,导致用户迷失方向。Orion 通过SLAM+VIO + 高频重投影实现世界锁定。

SLAM(即时定位与地图构建):通过朝外摄像头扫描环境,建立物理空间的 “点云地图”(如墙壁、沙发的几何位置)。

VIO(视觉惯性里程计):结合多摄像头与 IMU 传感器,实时计算眼镜在环境中的相对位置与角度。

高频协同优化:为平衡无线传输成本与体验流畅度,计算模块以非 90Hz 的较低频率传输核心渲染数据,眼镜端则以 90Hz 高频进行 SLAM/VIO 计算与画面重投影。 即便头部微动,虚拟内容仍能稳定锚定在物理空间,且 70 度视场角预留的边缘余量,避免头部移动导致内容被切断。

此外,空间音频作为补充,通过精准调整两耳音频的时序与强度,让虚拟内容的声音来自其物理位置(如虚拟人在左侧,声音即从左侧传来),避免 音画错位的违和感。

多模态输入融合

Orion 并未依赖单一输入方式,而是融合了眼动追踪、EMG、手部追踪、语音,形成了互补。

眼动追踪:定位用户注视焦点(如识别看向虚拟按钮)。

EMG 腕带:触发操作(如注视按钮时,手势触发点击)。

手部追踪:通过朝外摄像头捕捉手部位置,补充 EMG 的位置精度。

语音命令:应对复杂指令(如查询建筑历史),依托 AI 实现任意复杂度交互

典型场景:用户注视虚拟按钮(眼动追踪定位),通过 EMG 腕带做点击手势(触发操作),无需抬手或说话,交互自然且不打断当前状态。

AR的未来发展

Jinsong Yu 预测,未来 AR 行业将呈现多形态产品谱系,而非单一设备主导,具体分为四个层级。

第一为纯音频眼镜。仅含麦克风与扬声器,轻量化(极低克重)、长续航,支持音乐播放与 AI 语音交互。

第二个为带摄像头的智能眼镜,该类产品新增摄像头,可拍摄、识别环境(如伦敦街头识别历史建筑并讲解)。

第三为带简单显示器的眼镜,支持基础信息显示(如行人导航),无需频繁掏手机。

最后为全息3D AR眼镜,也就是 Orion 所属的品类,虽制造成本高,但仍是未来核心方向。未来将有更多企业推出覆盖全谱系的产品,竞争焦点集中在体验自然度与成本控制。

结语

Orion AR 眼镜的价值,不仅在于11 个定制 MCU、碳化硅波导等技术突破,更在于为 AR 行业提供了从技术研发到产品落地的完整路径。它证明 AR 设备可同时实现轻量化与功能完整性,也揭示了软硬件协同、多模态交互、产品谱系化将是未来AR发展的核心方向。